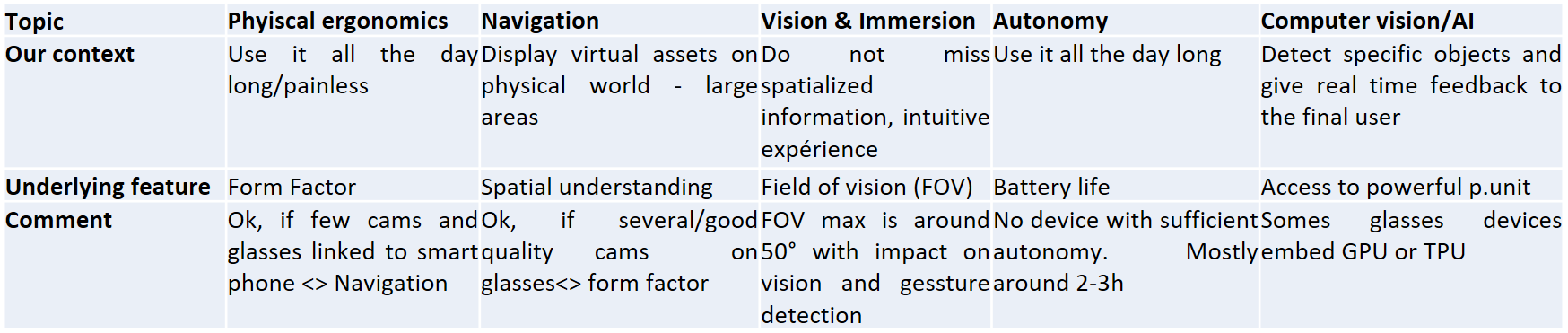

Quels critères pour choisir des lunettes de réalité augmentée ?

Retour d’expérience Lunettes de réalité augmentée

Cet article est un retour d’expérience sur des lunettes de réalité augmentée dans le cadre d’un usage industriel spécifique.

Il est question de réalité augmentée au sens spatialisée du terme, pas de simple visée haute ou d’assistance à distance.

Notre article est basé d’une étude très concrète sur les limites de l’état de l’art. Il s ‘agit d’explorer, de tester et d’utiliser une solution de réalité augmentée main libres en développant une application fonctionnelle. La description qui suit est détaillée mais pas exhaustive.

Contexte du projet et du retour d’expérience

Nous décrirons ce projet de façon technologique et ergonomique moins sur le métier : la finalité et le client restant confidentiels.

Pour des questions de neutralité technologique, nous ne citerons pas les différentes marques de lunettes que nous avons étudiées, mais aborderons les technologies sous-jacentes qui se retrouvent peu ou prou dans la majorité des périphériques.

Notre cas d’usage

Il s’agit d’« augmenter » un opérateur qui se déplace au sein de bâtiments. C’est-à-dire de lui afficher des informations supplémentaires concernant ses tâches.

Son itinéraire doit être balisé par un fil d’Ariane virtuel et des icônes 3D spatialisés sur les zones où il doit intervenir. La précision de localisation de ses hotspots est d’environ 50 cm.

L’opérateur a la possibilité de déclencher des actions, son activité mobilisant ses mains, il doit avoir les mains libres, donc pas un smartphone, il est primordial qu’il n’utilise pas d’interface tactile mais plutôt la voix ou la reconnaissance gestuelle.

Enfin, les lunettes doivent analyser des images et repérer des objets dans la vision de l’utilisateur pour l’aider à les localiser.

Le form factor

Un des critères déterminants du projet est bien le Form factor, c’est-à-dire la taille et l’encombrement du dispositif. Nous ciblons des lunettes légères et peu encombrantes puisque le cadre d’utilisation est bien de les utiliser sur un temps long. Nous ne sommes pas dans le cas d’un usage ponctuel, ciblé et stationnaire. Mais bien dans un contexte ou l’utilisateur va déambuler au sein de grands bâtiments avec une certaine liberté.

La discrimination est assez simple dans ce cas. Deux types de lunettes : celles qui embarquent la totalité de leur unité centrale et celles qui utilisent une unité centrale déportée comme le téléphone . C’est uniquement ce second type de lunettes qui permet d’obtenir des lunettes de faible encombrement, légères et supportables.

Notons aussi que nous avons opté aussi pour le mode unité centrale déporté et avons éliminé pour l’heure le mode « pass trough » qui se répand de plus en plus sur les casques de réalité virtuelle. Il permet d’obtenir de la réalité augmentée sur le flux vidéo récupéré par le casque de réalité virtuelle. L’avantage étant de bénéficier du grand champ de vision proposé par les casques, l’inconvénient étant leur Form factor bien trop volumineux et toujours une forme possible de claustrophobie.

La batterie

Un point faible commun aux lunettes de réalité augmentée : l’autonomie. On est en moyenne de 2h-2.5h d’autonomie. De plus notre cas d’usage est particulièrement éprouvant pour la batterie dans la mesure où il fait appel à la fois à de la réalité augmentée 3D mais aussi à de l’analyse d’images via de l’intelligence artificielle.

Champs de vision, opacité et affichage des informations virtuelles 3D

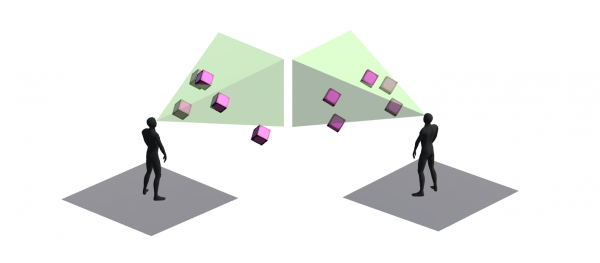

Le champ de vision (FOV) des lunettes de réalité augmentée est plus faible que la perception visuelle humaine ou plus faible que les casques de réalité virtuelle. Là où le champ de vision humain horizontal est d’environ 180°, celui des lunettes, pour les plus performantes, est autour de 50°. Le champ de vision vertical est encore plus réduit sur l’axe vertical.

Il en résulte que la visibilité du virtuel est contrainte dans un rectangle au milieu des lunettes. Il est donc tout à fait possible de passer à côté d’informations virtuelles spatialisées ou d’avoir une information augmentée littéralement coupée. Dans notre cas de figure, où pendant une navigation, nous devons afficher un fil d’Ariane au sol et où peuvent s’afficher des objets virtuels en vision périphérique, il est tout à fait possible de perde de l’information.

Ergonomiquement, en réalité augmentée, il est préférable de centraliser les informations au centre de l’écran, il s’agit donc d’un équilibre à trouver..

Les lunettes de réalité augmentée ont une opacité réduite, c’est-à-dire que les objets virtuels apparaissent de façon relativement transparente sur le monde réel et suivant leur performance sont plus ou moins efficaces dans la qualité d’affichage. Ce qui contraint leurs usages aux intérieurs.

La navigation

On parle ici de navigation « in door », donc sans système GPS/RTK au demeurant encore très encombrant. Avec l’impossibilité d’avoir recours à des installations trop lourdes comme le bornage wifi ou électromagnétique. Dont d’ailleurs, les performances sont à notre avis par encore suffisantes.

La solution repose avant tout sur un scanning de l’environnement préalable. Nous avons eu recours à différentes approches, mais avec, dans chaque cas, la nécessité de scanner des endroits particuliers ou la totalité de l’environnement.

En quelques mots, le scanning via un téléphone ou une tablette est relativement rapide, il permet de créer un modèle géométrique grossier de l’environnement. Les lunettes de réalité augmentée, grâce à leurs caméras embarquées, « reconnaissent » le modèle et de parce qu’elles en voient en déduisent la position et orientation. C’est le principe du SLAM

Nous l’avons testé, en utilisant pourtant plusieurs approches ou briques logicielles différentes. Sur des lunettes à Form factor acceptable, disposant de moins de caméras que des périphériques plus imposants. Cette approche s’est relevée décevante. Le tracking se perd régulièrement entrainant des dérives (ou drift) dans la juxtaposition entre le réel et le virtuel. Donc le fil d’Arianne ou les objets virtuels localisés ne se retrouvent progressivement plus à la bonne place.

Sur le téléphone le résultat est bien meilleur. En effet, la combinaison des caméras des systèmes inertiels associés à des librairies de réalité augmentée tel que ARCore ou ARkit adaptés aux téléphones rendent le SLAM beaucoup plus robuste que sur les lunettes. En raison de l’intrication device/SDK, ces SDK ne sont disponibles que dans les téléphones.

Au final, nous avons dû combiner le SLAM avec l’ajout de marqueurs noir et blancs, à intervalles réguliers, pour permettre au système de se recaler et de palier le drift.

L’interaction

L’expérience utilisateur est complexe en réalité augmentée, il y a tout d’abord l’affichage d’information qui doit être au maximum au centre de l’écran, faire appel à des icônes assez explicites et bien sûr avec parcimonie pour ne pas créer de surcharge cognitive chez l’opérateur.

Pour des questions à la fois de lisibilité et de simplification, il est préférable pour les informations spatialisées, d’afficher les informations sous formes d’objets/icones 3D ou 2D mais d’avoir le moins possible recours au texte.

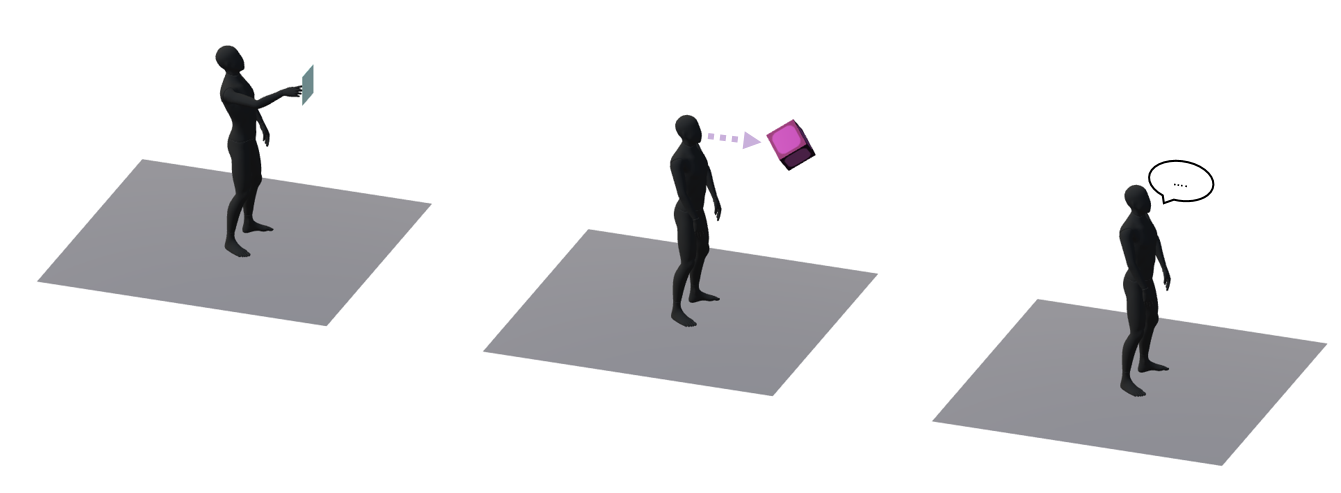

Geste, gaze et voix

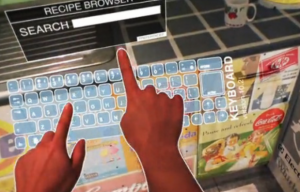

- La gestuelle consiste à effectuer certains gestes :

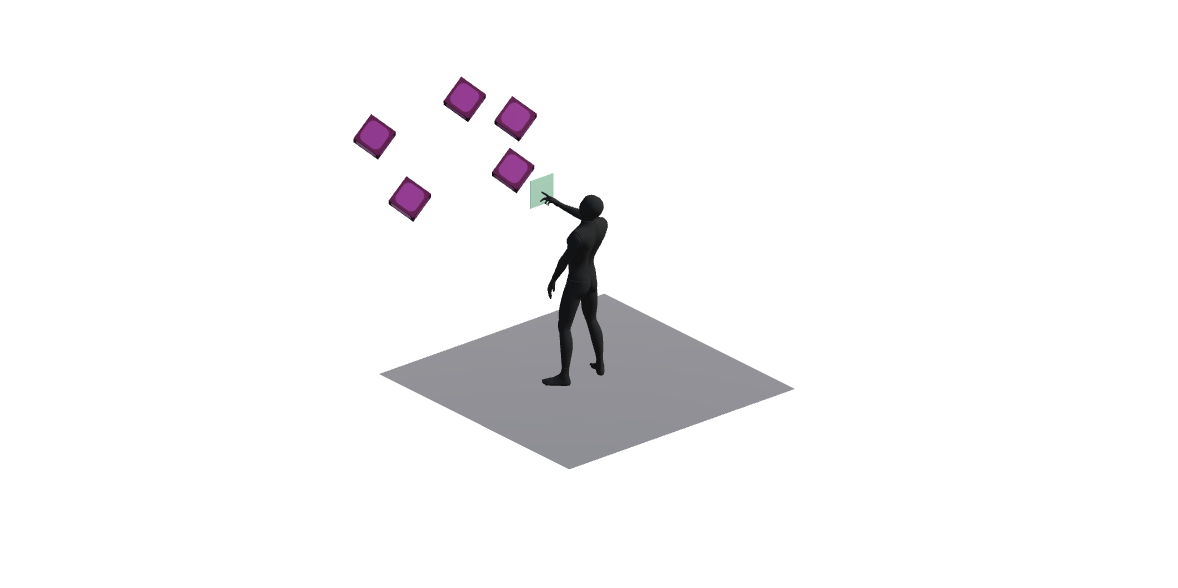

1/En utilisant l’index pour interagir avec des interfaces flottantes en 2D.

- L’absence de retour haptique : l’absence de contact physique avec le virtuel perturbe la perception de l’utilisateur. Il est important de renforcer par exemple l’état d’un bouton appuyé par un état visuel distinctif accompagné d’un effet sonore.

2/Des signalétiques sont des postures de mains, des gestes codés qui déclenchent une action comme par exemple l’apparition d’un menu.

Globalement, on notera que :

- Du fait du champ de vision limité des lunettes, l’obligation de lever la main haut peut rapidement devenir inconfortable est peu naturel. Ce sont donc des actions ponctuelles et rapides qu’il faut prévoir.

- L’utilisateur ne voit pas les frontières précises du champ visuel des lunettes, s’il met sa main dans son propre champs de vision, il ne saura pas nécessairement qu’il n’est pas dans celui des lunettes. Ce qui génère une possible impression de dysfonctionnement.

- Le gaze

Le gaze est un système de visée via les lunettes.

Regarder dans une direction en particulier équivaut au passage d’une souris sur une zone par exemple.

Dans notre cas, cela nous permet d’afficher le menu contextuel d’un objet virtuel.

- La voix

L’interaction à privilégier dans un environnement calme, sans voix ambiantes, pour une reconnaissance optimale. Dans le sens où elle est plus naturelle que la gestuelle sur interface virtuelle. Notre expérience s’est avérée concluante.

Computer vision et deep learning

Dans notre cas d’usage, il est nécessaire de détecter des objets dans le champ de vision de l’utilisateur.

Pour cela nous avons dû avoir créé un data set de deep learning avec un format d’image relativement modeste pour prendre en compte les limites de la caméra des limites et du processeur associé.

La principale contrainte que nous avons rencontrée est la sollicitation du processeur.

Utiliser le CPU du périphérique est assez limitant et il n’était pas trivial de mobiliser le GPU du smartphone. A terme, la possibilité d’utiliser un TPU (Tensor Processing Unit) qui commence à équiper les smart phones marquera un net progrès.

A noter que certaines lunettes embarquent leurs propres processeurs mais ce point est à mettre en contexte avec le Form factor.

Conclusion

Notre étude aborde de nombreux aspects technologiques liés à la réalité augmentée. Pour le moment, le niveau d’attente sur tous ces points à la fois n’est pas atteint.

Le Form factor est incompatible avec certaines attentes.